Kyutai 推出 Kyutai TTS – 专为实时场景打造的AI文本转语音神器,凭借超低延迟、高保真声音和流式处理能力,秒杀了很多竞品。不仅技术先进,还开源免费,适合开发者、内容创作者和 AI 爱好者使用。

什么是 Kyutai TTS? Kyutai TTS 是一个能把文字快速转换成语音的模型,最初是@kyutai_labs 团队在开发他们的 AI 助手 Moshi 时内部使用的工具。现在,这个 1.6B 参数的模型 (kyutai/tts-1.6b-en_fr) 开源了,供大家免费使用。它支持英语和法语,特别适合需要低延迟的实时场景,比如直播、语音助手或互动应用。

为什么它很牛? Kyutai TTS 在文本转语音领域表现非常出色,文章提到它在以下几个方面堪称“顶尖”: · 高准确度:通过“字错误率”(WER)测试,它在英语(2.82%)和法语(3.29%)的语音生成中错误极少,远超其他竞品,比如 ElevenLabs 或 Chatterbox · 声音逼真:它能模仿目标声音的语调、语气和录音质感,相似度高达 77.1%(英语)和 78.7%(法语) · 超低延迟:从接收文字到生成语音只需 220 毫秒(0.22 秒),即使多人同时使用(比如 32 个请求一起处理),延迟也只有 350 毫秒。这意味着它反应超快,特别适合实时对话 · 支持长文本:不像很多模型只能处理短音频(<30 秒),Kyutai TTS 可以生成超长音频,质量依然稳定

独特的技术亮点 Kyutai TTS 之所以这么强,靠的是几个创新设计: · 文本流式处理:传统 TTS 模型需要先知道完整文本才能开始生成语音,而 Kyutai TTS 可以一边接收文字一边生成语音。这对实时场景特别有用,比如当 AI 还在生成长文本时,语音已经开始播放了 · 延迟流建模(Delayed Streams Modeling):这是 Kyutai 团队独创的技术,简单来说,他们把文字和语音看作两条“平行”的流,语音稍微延迟一点(几帧),这样模型就能一边处理文字一边生成语音。这种设计还让语音和文字的时间对齐更精准,比如可以生成字幕或处理用户打断对话的场景 · 语音克隆:只需 10 秒的音频样本,模型就能模仿这个声音的风格。为保护隐私,他们不直接公开语音嵌入模型,而是提供了一个基于公开数据集(如 Expresso、VCTK)的语音库,还鼓励用户匿名捐赠自己的声音来丰富库 · 字级时间戳:生成语音的同时,模型还能告诉你每个单词的具体时间点。这功能很实用,比如可以实时生成字幕,或者在用户打断 AI 时,精准知道停在哪里,方便后续继续

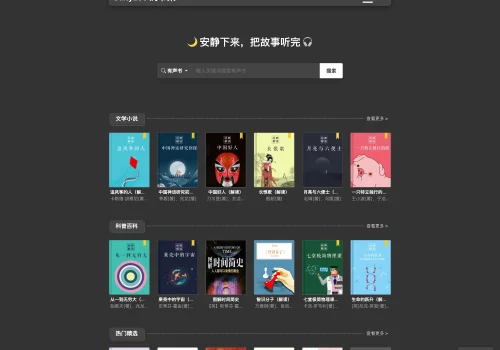

它能干啥? Kyutai TTS 的应用场景很广,尤其适合需要实时、交互性强的场合: · 实时语音助手:像 Unmute. sh 这样的平台,用它来实现超低延迟的语音交互 · 长音频生成:适合播客、有声书或新闻播报等需要长时间语音输出的场景 · 多语言支持:目前支持英语和法语,未来可能会扩展更多语言(他们的 LLM Helium 1 已经支持欧盟 24 种官方语言) · 生产级部署:Kyutai 提供了基于 Rust 的服务器和 Docker 镜像,方便开发者部署。文章提到,在 L40S GPU 上,它能同时处理 16 个连接,速度是实时的两倍以上

和其他模型比有什么优势? 对比了 Kyutai TTS 和其他主流 TTS 模型(比如 ElevenLabs、Chatterbox、Dia 等),它的优势很明显: · 更低的错误率:生成的语音更贴近输入文本 · 更高的声音相似度:克隆的声音更像原声 · 真正的流式处理:不仅音频流式,文本也是流式的,竞品大多需要完整文本才能开始 · 多任务优化:支持长音频、实时字幕、批量处理等,功能更全面

未来计划 · 更多语言支持:目前只有英语和法语,但团队正在探索扩展其他语言 · 语音转文本(STT):延迟流建模技术还能反过来做语音转文本,他们正在研究相关模型 · 学术分享:Kyutai 团队计划发布一篇详细论文,解释他们的技术细节。

暂无评论内容